Qu'est-ce que l'échelle de notation ?

Lorsque les développeurs de tests rapportent les scores de tests aux utilisateurs finaux (administrateurs scolaires, enseignants, parents, les candidats eux-mêmes ou d'autres utilisateurs potentiels de scores), il est important que la signification des scores numériques rapportés soit claire et facile à utiliser. Sinon, quel est l'intérêt des scores de tests ?

Les scores de épreuves peuvent se présenter sous de nombreuses formes différentes.

Par exemple, les scores de certains tests sont rapportés en termes de nombre correct ou de pourcentage correct. Un tel rapport est utile dans les cas où chaque participant au test passe exactement le même test, comme dans le cas des tests linéaires à forme fixe.

Les évaluations Avant STAMP (STAndards-based Measurement of Proficiency), cependant, utilisent des approches plus modernes de psychométrie et de développement de tests et ne sont pas des tests linéaires. Tous les tests de lecture et d'écoute STAMP sont adaptatifs sur ordinateur, ce qui signifie que la difficulté du test s'adapte en temps réel à l'aptitude linguistique estimée de chaque candidat. Cela se traduit par une mesure plus précise de la compétence linguistique des candidats et offre une expérience plus agréable que celle normalement associée à un test linéaire, car les candidats ne rencontreront pas un grand nombre d'éléments nettement inférieurs ou supérieurs à leur niveau réel de compétence. Cette puissante méthode d'assemblage et de déploiement de tests n'est possible qu'au moyen d'une technique psychométrique appelée théorie de la réponse à l'item (IRT). Dans l'IRT, chaque élément de test (c'est-à-dire chaque question de test) est associé à son propre niveau de difficulté mesuré scientifiquement. Dans le cas de STAMP, le niveau de difficulté de chaque élément du test est calculé grâce à une analyse IRT des réponses de centaines (et dans de nombreux cas, de milliers) de candidats représentatifs. Cela nous permet de calibrer les éléments en termes de difficulté et de nous assurer que seuls les meilleurs éléments sont utilisés dans chaque test STAMP.

L'algorithme de notation STAMP utilise également ces informations sur la difficulté de l'élément afin de calculer le niveau final STAMP de chaque candidat, en fonction des éléments qu'ils ont tenté pendant le test, leur réponse à chaque élément, et la capacité que les candidats doivent démontrer pour obtenir un score à chacun des niveaux STAMP (ce dernier est déterminé par un processus appelé standard setting). Par conséquent, compte tenu de la nature adaptative des évaluations STAMP et du fait que chaque élément a un certain niveau de difficulté statistique associé, la communication des scores STAMP en termes de nombre correct (par exemple, 23 sur 30) ou de pourcentage correct (76,6%) n'est ni significative ni appropriée.

Comme nous le discuterons bientôt, la théorie de la réponse à l'item (IRT), qui forme la base statistique du développement et de la notation des tests Avant STAMP, utilise une échelle de score qui n'est pas très intuitive pour les utilisateurs finaux des tests STAMP. Par exemple, l'échelle IRT a des valeurs négatives et positives. Dire à un candidat sur son rapport de score que sa compétence en lecture dans le test allemand STAMP 4S est de -1,4 ne serait pas utile et violerait l'exigence de scores clairs et faciles à utiliser discutée ci-dessus. Pour cette raison, il est nécessaire que les valeurs de score STAMP basées sur l'IRT soient converties en une échelle de score plus significative et facilement interprétable. Une échelle est essentiellement un spectre de valeurs de mesure potentielles et les développeurs de tests doivent décider des points de référence de l'échelle de score avant que les scores puissent être rapportés.

Comprendre les Points de Référence d'une Échelle

Trois échelles que les lecteurs connaissent probablement sont les échelles de température Celsius, Fahrenheit et Kelvin. Bien que toutes trois soient des échelles de température, leurs points de référence et leur interprétation diffèrent considérablement. La même chose peut s'appliquer à différentes échelles utilisées pour rapporter les scores de compétence linguistique.

Dans l'échelle Celsius, un degré de 0 ℃ indique le point de mesure où l'eau gèle au niveau de la mer, tandis que la valeur de mesure minimale possible sur l'échelle Celsius est de -273,15 ℃, qui est le point où il n'y a aucune activité moléculaire dans une substance. Cependant, sur l'échelle Fahrenheit, le point de mesure où l'eau gèle au niveau de la mer est de 32 degrés F, pas 0 degrés F. Sur l'échelle Fahrenheit, - 459,67 F indique la valeur de mesure minimale possible, lorsqu'il n'y a aucune activité moléculaire dans une substance. Comme nous pouvons le voir, ni dans l'échelle Celsius ni dans l'échelle Fahrenheit, un zéro ne signifie réellement l'absence complète de quelque chose. Il s'agit simplement d'un point de référence qui n'a de sens qu'en relation avec l'échelle complète et ses valeurs possibles et atteignables.

Pour les échelles de température, la seule échelle qui a un véritable point zéro est l'échelle Kelvin. Dans l'échelle Kelvin, le point de mesure 0 K signifie en réalité aucune activité moléculaire du tout, avec zéro marquant la valeur minimale possible dans l'échelle Kelvin. Dans l'échelle Kelvin, par conséquent, les valeurs négatives ne sont pas possibles, contrairement aux échelles Celsius et Fahrenheit (et comme nous le verrons bientôt, l'échelle IRT). Toutes les trois échelles de température n'ont pas de véritable limite à leurs valeurs maximales, puisqu'il n'y a pas de limite connue à la chaleur qu'un objet peut atteindre.

Maintenant, pouvons-nous vraiment dire qu'une échelle est meilleure que l'autre ? Pas vraiment. Les trois échelles sont parfaitement valables en soi et sont largement utilisées dans différents contextes, certaines échelles étant considérées comme plus appropriées par les utilisateurs en fonction de contextes spécifiques. Une chose qui unit ces trois échelles, cependant, et qui les rend parfaitement adaptées à une mesure précise, est le fait que la distance entre deux points de mesure sur l'échelle indique la même différence de température. En d'autres termes, la différence d'activité moléculaire entre 35 ℃ et 37 ℃ est exactement la même que celle entre 89 ℃ et 91 ℃. C'est une caractéristique que nous chez Avant croyons être au cœur d'une bonne mesure, et certainement une que nous utilisons pour nos scores STAMP.

Malgré l'utilité de regarder les trois échelles de température familières ci-dessus et de voir à quel point elles sont appropriées dans leurs contextes donnés pour la mesure d'une construction telle que la température, il est important de comprendre que certaines des caractéristiques qu'elles possèdent les rendent inappropriées pour la mesure d'une construction telle que la compétence linguistique. Par exemple, il serait pratiquement impossible d'expliquer ce que signifie une compétence linguistique négative ou comment quelqu'un peut avoir une capacité zéro dans une langue ; même une personne qui n'a jamais étudié ou été en contact avec une langue donnée auparavant aura une certaine (bien que minimale) connaissance d'au moins des mots empruntés dans cette langue. Aucun test de compétence linguistique ne peut prétendre que quelqu'un a une compétence linguistique nulle, car il serait impossible pour un test donné d'évaluer tous les scénarios possibles dans lesquels une personne peut montrer une certaine compréhension, même si elle est très basique, d'un mot ou d'une phrase dans la langue. Tous les tests de langue sont limités par les éléments présents dans le test et ce qu'ils sont capables de mesurer, ce qui signifie que les tests de langue peuvent ne pas avoir un point zéro de mesure, mais peuvent avoir un point minimum de mesure, représentant le point en dessous duquel le test est incapable de faire des affirmations. La même chose s'applique au point de référence maximum dans un test ; peu importe combien d'éléments un test contient, il ne sera jamais capable de mesurer toutes les compétences linguistiques d'un individu. En tant que tel, une échelle valide pour un test de compétence linguistique tel que les tests STAMP aura un point de référence minimum (utilisé pour les candidats qui obtiennent tous les éléments de test qu'ils ont vus incorrectement), aucun point de référence zéro, et aura un point de référence maximum (utilisé pour les candidats qui répondent correctement à tous les éléments de test qu'ils ont vus).

Mesure IRT et les scores STAMP

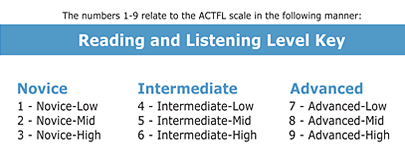

Comme mentionné ci-dessus, il est important que des intervalles égaux dans une échelle utilisée pour rapporter les scores d'un test de compétence linguistique indiquent la même différence de compétence linguistique. Tous les niveaux du test STAMP (niveaux 1 à 9) sont alignés sur les niveaux standard de compétence linguistique américains (Débutant(e) Low à Advanced High), comme on peut le voir ci-dessous :

Malgré l'alignement des niveaux STAMP sur ces niveaux de compétence et malgré l'utilité de ces niveaux de compétence pour indiquer le niveau général de compétence d'un candidat dans la langue, les niveaux de normes eux-mêmes ne correspondent pas au type de scores échelonnés numériques que nous recherchons. Premièrement, la signification de la différence d'intervalle dans les normes nationales de compétence (et donc STAMP) n'est pas la même quel que soit le point sur l'échelle. Par exemple, il faut un niveau de compétence linguistique plus élevé pour passer de l'Intermédiaire Haut (niveau STAMP 6) à l'Avancé Bas (niveau STAMP 7) qu'il n'en faut pour passer du Débutant(e) Haut (niveau STAMP 3) à l'Intermédiaire Bas (niveau STAMP 4). Pour cette raison précise, les niveaux de compétence sont représentés sous forme de pyramide inversée, et non pas sous forme de carré ou de rectangle. Deuxièmement, malgré l'utilité des niveaux de compétence pour indiquer où se situe un certain apprenant de langue en termes de compétence linguistique, les étudiants ayant obtenu le même niveau STAMP peuvent en réalité avoir des compétences légèrement différentes dans la langue et peuvent avoir répondu correctement à un nombre différent d'éléments dans le test STAMP, même s'ils ont vu exactement les mêmes éléments grâce à l'algorithme adaptatif STAMP. Par conséquent, malgré l'utilité importante des niveaux STAMP et des normes nationales de compétence pour comprendre la compétence linguistique des candidats, ces niveaux ne sont pas aussi précis que certains utilisateurs finaux de nos scores de test aimeraient qu'ils le soient.

Par exemple, une école peut n'avoir que dix places dans une section spéciale d'honneur de lecture en français. Que se passe-t-il si quatorze des étudiants ont atteint un niveau 9 STAMP en lecture ? Comment l'école peut-elle choisir 10 parmi les 14 étudiants pour la classe d'honneur ? Choisir dix élèves au hasard peut être considéré comme une solution acceptable, mais nous chez Avant Assessment pouvons fournir une meilleure et plus précise manière d'aider dans ce cas. Comme mentionné ci-dessus, Avant Assessment utilise une technique de mesure statistique appelée Théorie de la Réponse à l'Item pour calibrer tous les éléments des sections de lecture et d'écoute des tests STAMP (adaptatifs), pour aligner le nombre de questions qu'un candidat répond correctement dans son parcours de test spécifique sur les niveaux STAMP et donc sur les niveaux de normes de compétence nationales auxquels ils sont alignés, et pour finalement produire des scores échelonnés qui fournissent aux utilisateurs de scores une mesure plus fine de la capacité linguistique de chaque candidat que ce ne serait possible si seuls les niveaux STAMP étaient rapportés.

Mise à l'échelle des scores STAMP

Une fois que tous les éléments d'une section spécifique d'un test STAMP ont été calibrés par l'IRT, nous sommes en mesure d'attribuer une estimation de capacité IRT (également appelée thêta dans la terminologie IRT) à chaque étudiant en fonction des éléments qu'ils ont corrects ou incorrects dans le chemin spécifique qu'ils ont suivi dans chacune des sections de lecture et d'écoute de leur test STAMP. Une fois que nous avons cette valeur, nous sommes alors en mesure de mettre à l'échelle cette valeur (d'où le terme, mise à l'échelle des scores) afin que nous puissions rapporter des scores plus précis, afin de compléter le rapport du niveau STAMP atteint. En mettant à l'échelle les scores IRT, nous sommes alors en mesure de garantir que tous les scores mis à l'échelle sont positifs (pas de valeurs négatives) et que les utilisateurs de scores, comme l'école française hypothétique ci-dessus, sont en mesure de se concentrer davantage sur la compétence des élèves, même si les élèves ont obtenu le même niveau STAMP.

Chacune des sections de Lecture et d'Écoute de chaque test STAMP doit être échelonnée séparément. Par conséquent, les scores échelonnés pour la lecture en espagnol ne peuvent pas être comparés directement avec les scores échelonnés pour l'écoute en espagnol, ou avec les scores échelonnés pour la lecture en chinois. En d'autres termes, les scores échelonnés STAMP sont spécifiques à la langue et à la section.

Nous mettons à l'échelle les scores IRT dans les sections de Lecture ou d'Écoute de chacun de nos tests grâce à une simple transformation linéaire, visible dans la formule ci-dessous :

La mise à l'échelle ci-dessus garantit que tous les scores échelonnés possibles pour une section donnée d'un test STAMP sont des nombres positifs sans décimales, ce qui est beaucoup plus intuitif que des scores allant de - 4 à + 4, qui sont plus typiques de l'IRT. La mise à l'échelle linéaire visible dans la formule ci-dessus garantit également que la distance entre deux scores échelonnés indique la même différence de capacité à n'importe quel point de l'échelle.

Interprétation des Scores Échelonnés

Imaginez que nous avons les étudiants suivants, qui ont passé la section d'écoute du test japonais STAMP 4S :

- Étudiant A score ajusté : 589

- Étudiant B score ajusté : 612

- Étudiant C score ajusté : 677

- Étudiant D score ajusté : 700

La différence de compétence en écoute du japonais entre le Étudiant A et le Étudiant B en japonais (23 points échelonnés) est la même que la différence de compétence en écoute du japonais entre le Étudiant C et le Étudiant D (23 points). Si deux étudiants ont atteint le même niveau STAMP en écoute du japonais (par exemple, niveau STAMP 4 - Intermédiaire Bas), mais que l'un d'eux a un score échelonné qui est de 20 points supérieur à l'autre, nous avons de solides raisons de croire que l'étudiant avec le score échelonné le plus élevé est plus compétent que l'étudiant avec le score échelonné le plus bas. Plus la différence entre leurs scores échelonnés est grande, plus nous pouvons être confiants que la différence est significative et que les deux étudiants ne sont effectivement pas également compétents. Les scores échelonnés peuvent également être utiles dans les cas où un étudiant semble ne pas progresser après une année d'étude et semble être "coincé" au même niveau de compétence. Une comparaison entre leur score échelonné il y a un an et leur score échelonné lors de l'administration actuelle peut montrer de petits gains progressifs dans leur compétence, même si ces augmentations n'étaient pas suffisantes pour les faire passer au niveau STAMP suivant.

Une chose doit être gardée à l'esprit, cependant : toutes les évaluations ont une certaine marge d'erreur de mesure associée à leurs scores. Par exemple, l'erreur standard de mesure (SEM) rapportée par l'ETS pour la section d'écoute du TOEFL iBT, qui utilise une échelle de scores allant de 0 à 30, est de 2,38 points ajustés (Educational épreuvesing Services, 2018). À son tour, pour les scores de la section SAT, avec une plage de scores de 200 à 800, l'erreur standard de mesure est de 30 points (College Board, 2018). Comme il n'est pas faisable d'évaluer chaque étudiant sur de nombreux jours différents, et sur des centaines d'éléments de test, chaque résultat de test est un instantané du niveau qu'un candidat donné a pu maintenir le jour spécifique où il a passé le test, et sur les éléments spécifiques auxquels ils ont répondu lors de leur administration de test. Naturellement, un test comme le STAMP 4S, dont les sections de lecture et d'écoute sont adaptatives sur ordinateur, qui comprend un grand nombre d'éléments ciblant le niveau estimé de chaque candidat en temps réel, et qui est développé selon des normes qualitatives et quantitatives strictes, aura tendance à avoir une plus petite erreur de mesure et à être plus efficace et efficient que les tests linéaires plus courts, non adaptatifs, qui ne suivent pas la même rigueur (Schultz, Whitney, & Zickar, 2014). L'erreur standard moyenne de mesure pour les scores ajustés dans les sections de lecture et d'écoute des tests STAMP est de 10 points de score ajusté. Cette statistique est facilement dérivée du type de logiciel IRT que nous utilisons chez Avant.

L'erreur de mesure associée aux scores échelonnés du STAMP est assez petite compte tenu de la rigueur psychométrique et de la nature adaptative de nos tests. Bien que nous conseillons que les analyses des scores de test soient effectuées principalement sur la base du niveau STAMP atteint, nous chez Avant suggérons que les scores échelonnés peuvent être pris en compte dans des cas très spécifiques lorsque des décisions de plus grande importance doivent être prises sur la base des scores de test STAMP, comme lorsque les scores STAMP sont utilisés pour attribuer les Sceaux de compétences bilingues des états (SSB) ou pour attribuer des crédits par examen (CBE). Dans de tels cas de plus grande importance, si le score échelonné d'un candidat en lecture ou en écoute se trouve à 10 points ou moins du score échelonné minimum qui pourrait le qualifier pour le SSB ou le CBE, la position d'Avant est qu'une école ou un district peut, à leur discrétion, faire repasser le test STAMP à ces candidats (étant donné sa nature adaptative, il y a de bonnes chances que les candidats au test ne voient pas exactement les mêmes éléments que lors de l'administration précédente). Si lors de cette seconde administration le score échelonné du candidat conduit à un niveau STAMP qui répond aux exigences pour le SSB ou le CBE, la position d'Avant est que les scores de cette seconde administration peuvent être utilisés à la place des scores de la première administration.

Les deux scénarios discutés ci-dessus sont des scénarios à enjeux plus élevés où la prise en compte de la petite marge d'erreur du test peut être justifiée (n'oubliez pas que tous les tests ont une marge d'erreur).

Nous recommandons qu'il soit généralement approprié d'utiliser les scores échelonnés du STAMP pour des utilisations traditionnelles telles que pour l'analyse annuelle continue ou la croissance des élèves et pour l'évaluation du programme.

Pour voir les tableaux de scores ajustés actuellement disponibles pour les évaluations STAMP, cliquez ici.

Références:

College Board (2018). SAT : Comprendre les scores. Récupéré de https://collegereadiness.collegeboard.org/pdf/understanding-sat-scores.pdf

Services Éducatifs de épreuves (2018). Fiabilité et Comparabilité des Scores TOEFL iBT. Série de Recherches TOEFL (vol. 3). Récupéré de www.ets.org/s/toefl/pdf/toefl_ibt_research_s1v3.pdf

Schultz, K. S., Whitney, D. J., & Zickar, M. J. (2014). La théorie de la mesure en action. Études de cas et exercices (2e éd.). Londres/New York : Routledge. College Board (2018). SAT : Comprendre les scores. Récupéré de https://collegereadiness.collegeboard.org/pdf/understanding-sat-scores.pdf

Services Éducatifs de épreuves (2018). Fiabilité et Comparabilité des Scores TOEFL iBT. Série d'Aperçus de Recherche TOEFL (vol. 3). Récupéré de www.ets.org/s/toefl/pdf/toefl_ibt_research_s1v3.pdf

Schultz, K. S., Whitney, D. J., & Zickar, M. J. (2014). Théorie de la mesure en action. Études de cas et exercices (2ème éd.). Londres/New York : Routledge.