¿Qué es la Escalación de Puntuación?

Cuando los desarrolladores de pruebas informan las calificaciones de las pruebas a los usuarios finales (administradores escolares, profesores, padres, los propios examinados u otros posibles usuarios de las calificaciones), es importante que el significado de las calificaciones numéricas informadas sea claro y fácil de usar. Si no, ¿cuál es el punto de las calificaciones de las pruebas?

Las calificaciones de los exámenes pueden presentarse en muchas formas diferentes.

Por ejemplo, las puntuaciones en algunas pruebas se informan en términos de número correcto o porcentaje correcto. Tal informe es útil en casos en que cada participante de la prueba realiza exactamente la misma prueba, como en el caso de las pruebas lineales de forma fija.

Las evaluaciones Avant STAMP (STAndards-based Measurement of Proficiency), sin embargo, hacen uso de enfoques más modernos de psicometría y desarrollo de pruebas y no son pruebas lineales. Todas las pruebas de Lectura y Escucha de STAMP son adaptativas por computadora, lo que significa que la dificultad de la prueba se adapta en tiempo real a la capacidad lingüística estimada de cada examinado. Esto resulta en una medición más precisa de la competencia lingüística de los examinados y proporciona una experiencia más agradable para ellos que lo que normalmente es el caso con una prueba lineal, ya que los examinados no se encontrarán con un gran número de ítems sustancialmente por debajo o por encima de su nivel real de competencia. Este potente enfoque de ensamblaje y despliegue de pruebas solo es posible mediante una técnica psicométrica llamada teoría de respuesta al ítem (IRT). En IRT, cada ítem de prueba (también conocido como pregunta de prueba) se asocia con su propio nivel de dificultad medido científicamente. En el caso de STAMP, el nivel de dificultad de cada ítem en la prueba se calcula a través de un análisis IRT de las respuestas de cientos (y en muchos casos, miles) de examinados representativos. Esto nos permite calibrar los ítems en términos de su dificultad y asegurarnos de que solo los mejores ítems se usen en cada prueba STAMP.

El algoritmo de puntuación STAMP también hace uso de esta información de dificultad del ítem para calcular el nivel final STAMP de cada examinado, basado en qué ítems intentaron durante la prueba, su respuesta a cada ítem, y la habilidad que los examinados necesitan demostrar para puntuar en cada uno de los niveles STAMP (este último se determina a través de un proceso llamado establecimiento de estándares). Por lo tanto, dada la naturaleza adaptativa de las evaluaciones STAMP y dado que cada ítem tiene un cierto nivel estadístico de dificultad asociado con él, informar las puntuaciones STAMP en términos de número correcto (por ejemplo, 23 de 30) o porcentaje correcto (76.6%) no es ni significativo ni apropiado.

Como discutiremos pronto, la teoría de respuesta al ítem (IRT), que forma la base estadística del desarrollo y la puntuación de las pruebas Avant STAMP, utiliza una escala de puntuación que no es muy intuitiva para los usuarios finales de las pruebas STAMP. Por ejemplo, la escala IRT tiene valores tanto negativos como positivos. Decirle a un examinado en su informe de puntuación que su competencia lectora en el examen alemán STAMP 4S es -1.4 no sería útil y violaría el requisito de puntuaciones claras y fáciles de usar discutido anteriormente. Por esta razón, es necesario que los valores de puntuación de STAMP basados en IRT se conviertan a una escala de puntuación más significativa y fácilmente interpretable. Una escala es básicamente un espectro de valores de medición potenciales y los desarrolladores de pruebas tienen que decidir sobre los puntos de referencia de la escala de puntuación antes de que se puedan informar las puntuaciones.

Entendiendo los Puntos de Referencia de una Escala

Tres escalas con las que los lectores probablemente estén familiarizados son las escalas de temperatura Celsius, Fahrenheit y Kelvin. Aunque las tres son escalas de temperatura, sus puntos de referencia e interpretación difieren sustancialmente. Lo mismo puede aplicarse a diferentes escalas utilizadas para informar sobre las puntuaciones de competencia lingüística.

En la escala Celsius, un grado de 0 ℃ indica el punto de medición en el que el agua se congela a nivel del mar, mientras que el valor de medición mínimo posible en la escala Celsius es -273.15 ℃, que es el punto en el que no hay actividad molecular en una sustancia. En la escala Fahrenheit, sin embargo, el punto de medición en el que el agua se congela a nivel del mar es 32 grados F, no 0 grados F. En la escala Fahrenheit, - 459.67 F indica el valor de medición mínimo posible, cuando no hay actividad molecular en una sustancia. Como podemos ver, en ninguna de las escalas, Celsius ni Fahrenheit, un cero significa realmente la ausencia completa de algo. Simplemente es un punto de referencia que solo tiene sentido con respecto a la escala completa y sus posibles valores alcanzables.

Para las escalas de temperatura, la única escala que tiene un verdadero punto cero es la escala Kelvin. En la escala Kelvin, el punto de medición 0 K significa realmente ninguna actividad molecular en absoluto, con cero marcando el valor mínimo posible en la escala Kelvin. En la escala Kelvin, por lo tanto, no son posibles los valores negativos, a diferencia de las escalas Celsius y Fahrenheit (y como veremos en breve, la escala IRT). Las tres escalas de temperatura no tienen un límite real para sus valores máximos, ya que no se conoce un límite para cuán caliente puede ser algo.

Ahora, ¿podemos decir realmente que una escala es mejor que la otra? Realmente no. Las tres escalas son perfectamente válidas por sí mismas y se utilizan ampliamente en diferentes contextos, con ciertas escalas consideradas más apropiadas por los usuarios dependiendo de contextos específicos. Sin embargo, una cosa que une a estas tres escalas, y que las hace perfectamente adecuadas para una medición precisa, es el hecho de que la distancia entre cualquier dos puntos de medición en la escala indica la misma diferencia de temperatura. En otras palabras, la diferencia en la actividad molecular entre 35 ℃ y 37 ℃ es exactamente la misma que entre 89 ℃ y 91 ℃. Esta es una característica que en Avant creemos que está en el corazón de una buena medición, y ciertamente una que utilizamos para nuestras puntuaciones STAMP.

A pesar de la utilidad de observar las tres escalas de temperatura familiares mencionadas anteriormente y ver cuán apropiadas son en sus contextos dados para la medición de un constructo como la temperatura, es importante entender que algunas de las características que poseen las hacen inapropiadas para la medición de un constructo como la competencia lingüística. Por ejemplo, resultaría prácticamente imposible explicar qué significa una competencia lingüística negativa o cómo alguien puede tener cero habilidad en un idioma; incluso una persona que nunca ha estudiado o estado en contacto con un idioma dado anteriormente tendrá algún (aunque mínimo) conocimiento de al menos palabras prestadas en ese idioma. Ninguna prueba de competencia lingüística puede afirmar que alguien tiene cero competencia lingüística, ya que sería imposible para una prueba dada evaluar todos los escenarios posibles en los que una persona puede mostrar algún, incluso si muy básico, entendimiento de una palabra o frase en el idioma. Todas las pruebas de idiomas están limitadas por los elementos presentes en la prueba y lo que son capaces de medir, lo que significa que las pruebas de idiomas pueden no tener un punto cero de medición, pero pueden tener un punto mínimo de medición, representando el punto por debajo del cual la prueba es incapaz de hacer cualquier afirmación. Lo mismo se aplica al punto máximo de referencia en una prueba; no importa cuántos elementos contenga una prueba, nunca será capaz de medir toda la competencia lingüística de un individuo. Como tal, una escala válida para una prueba de competencia lingüística como las pruebas STAMP tendrá un punto de referencia mínimo (utilizado para los examinados que responden incorrectamente a todos los elementos de la prueba que vieron), no tendrá un punto de referencia cero, y tendrá un punto de referencia máximo (utilizado para los examinados que responden correctamente a todos los elementos de la prueba que vieron).

Medición IRT y las Puntuaciones STAMP

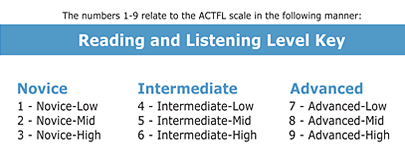

Como se mencionó anteriormente, es importante que los intervalos iguales en una escala utilizada para informar las puntuaciones en una prueba de competencia lingüística indiquen la misma diferencia en la competencia lingüística. Todos los niveles de la prueba STAMP (niveles 1 - 9) están alineados con los niveles estándar de competencia lingüística de EE. UU. (Principiante Low through Advanced High), como se puede ver a continuación:

A pesar de la alineación de los niveles de STAMP con estos niveles de competencia y a pesar de la utilidad de los niveles de competencia para indicar el nivel general de habilidad de un examinado en el idioma, los niveles de estándares en sí mismos no se ajustan al tipo de puntuaciones escaladas numéricas que estamos buscando. En primer lugar, el significado de la diferencia de intervalo en los estándares de competencia nacional (y por lo tanto STAMP) niveles no es el mismo independientemente del punto en la escala. Por ejemplo, se necesita una mayor cantidad de habilidad en el idioma para pasar de Intermedio Alto (nivel STAMP 6) a Avanzado Bajo (nivel STAMP 7) de lo que se necesita para pasar de Principiante Alto (nivel STAMP 3) a Intermedio Bajo (nivel STAMP 4). Por esta misma razón, los niveles de competencia se representan como una pirámide invertida, y no como un cuadrado o rectángulo. En segundo lugar, a pesar de la utilidad de los niveles de competencia para indicar dónde se encuentra un determinado aprendiz de idiomas en términos de su competencia lingüística, los estudiantes que obtienen la misma puntuación en el nivel STAMP pueden tener habilidades ligeramente diferentes en el idioma y pueden haber respondido correctamente a un número diferente de ítems en la prueba STAMP, incluso si resulta que han visto exactamente los mismos ítems a través del algoritmo adaptativo de STAMP. Por lo tanto, a pesar de la importante utilidad de los niveles de STAMP y los estándares de competencia nacional para entender la competencia lingüística de los examinados, estos niveles no son tan detallados como algunos usuarios finales de nuestras puntuaciones de prueba desearían que fueran.

Por ejemplo, una escuela puede tener solo diez asientos en una sección especial de honor de Lectura en Francés. ¿Qué pasa si catorce de los estudiantes han alcanzado un nivel 9 en Lectura en el STAMP? ¿Cómo puede la escuela seleccionar a 10 de los 14 estudiantes para la clase de honor? Elegir al azar a diez puede ser considerado una solución aceptable, pero nosotros en Avant Assessment podemos proporcionar una manera mejor y más precisa de ayudar en este caso. Como se mencionó anteriormente, Avant Assessment utiliza una técnica de medición estadística llamada Teoría de Respuesta al Ítem para calibrar todos los ítems en las secciones de Lectura y Escucha de las pruebas (adaptativas) STAMP, para alinear el número de preguntas que un examinado acierta en su camino específico de prueba con los niveles STAMP y por lo tanto los niveles de estándares de competencia nacional a los que están alineados, y finalmente, producir puntuaciones escaladas que proporcionan a los usuarios de las puntuaciones una medida más detallada de la habilidad lingüística de cada examinado de lo que sería posible si solo se informaran los niveles STAMP.

Escalando las Puntuaciones STAMP

Una vez que todos los elementos de una sección específica de una prueba STAMP han sido calibrados a través de IRT, somos capaces de asignar una estimación de habilidad IRT (también conocida como theta en la terminología IRT) a cada estudiante basándonos en los elementos que acertaron o fallaron en el camino específico que siguieron en cada una de las secciones de Lectura y Escucha de su prueba STAMP. Una vez que tenemos este valor, somos capaces de escalar este valor (de ahí el término, escalado de puntuación) para que podamos informar puntuaciones más detalladas, con el fin de complementar la notificación del nivel STAMP alcanzado. Al escalar las puntuaciones IRT, somos capaces de asegurar que todas las puntuaciones escaladas son positivas (sin valores negativos) y que los usuarios de las puntuaciones, como la hipotética escuela francesa mencionada anteriormente, pueden enfocarse más en la competencia de los estudiantes, incluso si los estudiantes resultan haber obtenido el mismo nivel STAMP.

Cada una de las secciones de Lectura y Escucha de cada prueba STAMP debe ser escalada por separado. Por lo tanto, las puntuaciones escaladas para la Lectura en Español no pueden compararse directamente con las puntuaciones escaladas para la Escucha en Español, o con las puntuaciones escaladas para la Lectura en Chino. En otras palabras, las puntuaciones escaladas STAMP son específicas para el idioma y la sección.

Escalamos las puntuaciones IRT en las secciones de Lectura o Escucha de cada una de nuestras pruebas a través de una simple transformación lineal, vista en la fórmula a continuación:

La escala superior asegura que todas las posibles puntuaciones escaladas para una sección dada de una prueba STAMP son números positivos sin decimales, que son mucho más intuitivos que las puntuaciones que varían de -4 a +4, que son más típicas de IRT. La escala lineal vista en la fórmula superior también asegura que la distancia entre cualquier dos puntuaciones escaladas indica la misma diferencia de habilidad en cualquier punto de la escala.

Interpretación de las Puntuaciones Escaladas

Imagina que tenemos los siguientes estudiantes, quienes tomaron la sección de Escucha del examen japonés STAMP 4S:

- Estudiante A puntuación escalada: 589

- Estudiante B puntuación escalada: 612

- Estudiante C puntuación escalada: 677

- Estudiante D puntuación escalada: 700

La diferencia en la competencia auditiva en japonés entre el Estudiante A y el Estudiante B en japonés (23 puntos escalados) es la misma que la diferencia en la competencia auditiva en japonés entre el Estudiante C y el Estudiante D (23 puntos). Si dos estudiantes alcanzaron el mismo nivel STAMP en Comprensión Auditiva en Japonés (por ejemplo, nivel STAMP 4 - Intermedio Bajo), pero uno de ellos tuvo una puntuación escalada que es 20 puntos por encima del otro, tenemos un fuerte respaldo para creer que el estudiante con la puntuación escalada más alta es más competente que el estudiante con la puntuación escalada más baja. Cuanto mayor sea la diferencia entre sus puntuaciones escaladas, más seguros podemos estar de que la diferencia es significativa y que los dos estudiantes efectivamente no son igualmente competentes. Las puntuaciones escaladas también pueden ser útiles en casos donde un estudiante puede parecer que no está progresando después de un año de estudio y está "atascado" en el mismo nivel de competencia. Una comparación entre su puntuación escalada hace un año y su puntuación escalada de la administración actual puede mostrar pequeñas ganancias incrementales en su competencia, incluso si tales incrementos no fueron suficientes para moverlos al siguiente nivel STAMP.

Debe tenerse en cuenta una cosa, sin embargo: todas las evaluaciones tienen un cierto margen de error de medición asociado con sus puntuaciones. Por ejemplo, el error estándar de medición (SEM) reportado por ETS para la sección de Listening del TOEFL iBT, que utiliza una escala de puntuación que va de 0 a 30, es de 2.38 puntos escalados (Educational Testing Services, 2018). A su vez, para las puntuaciones de la sección SAT, con un rango de puntuación de 200 a 800, el error estándar de medición es de 30 puntos (College Board, 2018). Dado que no es factible evaluar a cada estudiante en muchos días diferentes, y en cientos de elementos de prueba, cada resultado de prueba es una instantánea del nivel que un determinado examinado pudo mantener en ese día específico en que tomó la prueba, y en los elementos específicos que respondió durante su administración de la prueba. Naturalmente, una prueba como la STAMP 4S, cuyas secciones de Reading y Listening son adaptativas por computadora, que incluye un gran número de elementos dirigidos al nivel estimado de cada examinado en tiempo real, y que se desarrolla con estrictos estándares cualitativos y cuantitativos, tenderá a tener un error de medición más pequeño y será más efectiva y eficiente que las pruebas lineales más cortas, no adaptativas, que no siguen el mismo rigor (Schultz, Whitney, & Zickar, 2014). El error estándar promedio de medición para las puntuaciones escaladas en las secciones de Reading y Listening de las pruebas STAMP es de 10 puntos de puntuación escalada. Esta estadística se deriva fácilmente del tipo de software IRT que empleamos en Avant.

El error de medición asociado con las puntuaciones escaladas del STAMP es bastante pequeño dado el rigor psicométrico y la naturaleza adaptativa de nuestras pruebas. Aunque aconsejamos que los análisis de las puntuaciones de las pruebas se realicen principalmente en base al nivel alcanzado en el STAMP, en Avant sugerimos que las puntuaciones escaladas pueden ser consideradas en casos muy específicos cuando se deben tomar decisiones de mayor importancia basadas en las puntuaciones de las pruebas STAMP, como cuando las puntuaciones del STAMP se utilizan para otorgar Sellos Estatales de Bilingüismo (SSB) o para otorgar crédito por examen (CBE). En tales casos de mayor importancia, si la puntuación escalada de un examinado en Lectura o Escucha resulta estar a 10 puntos o menos de la puntuación escalada mínima que podría calificarlos para el SSB o el CBE, la posición de Avant es que una escuela o distrito puede, a su discreción, hacer que dichos examinados vuelvan a tomar la prueba STAMP (dada su naturaleza adaptativa, hay una buena posibilidad de que los examinados no vean exactamente los mismos ítems que en la administración anterior). Si en esta segunda administración la puntuación escalada del examinado lleva a un nivel de STAMP que cumple con los requisitos para el SSB o el CBE, la posición de Avant es que las puntuaciones de esta segunda administración pueden ser utilizadas en lugar de las puntuaciones de la primera administración.

Los dos escenarios discutidos anteriormente son escenarios de mayor riesgo en los que puede ser justificable considerar el pequeño margen de error de la prueba (recuerde que todas las pruebas tienen un margen de error).

Recomendamos que generalmente es apropiado utilizar las puntuaciones escaladas de STAMP para usos tradicionales como el análisis anual continuo o el crecimiento de los estudiantes y para la evaluación del programa.

Para ver las tablas de puntuaciones escaladas actualmente disponibles para las evaluaciones STAMP, haga clic aquí.

Referencias:

College Board (2018). SAT: Comprendiendo las Puntuaciones. Recuperado de https://collegereadiness.collegeboard.org/pdf/understanding-sat-scores.pdf

Educational Testing Services (2018). Fiabilidad y Comparabilidad de las Puntuaciones del TOEFL iBT. Serie de Investigación TOEFL (vol. 3). Recuperado de www.ets.org/s/toefl/pdf/toefl_ibt_research_s1v3.pdf

Schultz, K. S., Whitney, D. J., & Zickar, M. J. (2014). Teoría de la Medición en acción. Estudios de casos y ejercicios (2da ed.). Londres/Nueva York: Routledge. College Board (2018). SAT: Comprendiendo las Puntuaciones. Recuperado de https://collegereadiness.collegeboard.org/pdf/understanding-sat-scores.pdf

Educational Testing Services (2018). Fiabilidad y Comparabilidad de las Puntuaciones del TOEFL iBT. Serie de Investigación TOEFL Insight (vol. 3). Recuperado de www.ets.org/s/toefl/pdf/toefl_ibt_research_s1v3.pdf

Schultz, K. S., Whitney, D. J., & Zickar, M. J. (2014). Teoría de la Medición en acción. Estudios de caso y ejercicios (2da ed.). Londres/Nueva York: Routledge.