Was ist Score Scaling?

Wenn Testentwickler Testergebnisse an Endbenutzer (Schuladministratoren, Lehrer, Eltern, die Testteilnehmer selbst oder andere potenzielle Punktenutzer) melden, ist es wichtig, dass die Bedeutung der gemeldeten numerischen Ergebnisse klar und einfach zu verwenden ist. Wenn nicht, was ist der Sinn von Testergebnissen?

Testergebnisse können in vielen verschiedenen Varianten vorliegen.

Zum Beispiel werden die Ergebnisse in einigen Tests in Form von korrekten Zahlen oder korrekten Prozentsätzen angegeben. Eine solche Berichterstattung ist nützlich in Fällen, in denen jeder einzelne Testteilnehmer genau denselben Test macht, wie im Fall von linearen, festgelegten Tests.

Die Avant STAMP (STAndards-basierte Messung der Profizienz) Bewertungen nutzen jedoch modernere psychometrische und Testentwicklungsansätze und sind nicht lineare Tests. Alle STAMP Lesen- und Hören-Tests sind computeradaptiv, was bedeutet, dass sich der Schwierigkeitsgrad des Tests in Echtzeit an die geschätzte Sprachfähigkeit jedes Testteilnehmers anpasst. Dies führt zu einer genaueren Messung der Sprachkompetenz der Testteilnehmer und bietet im Vergleich zu einem linearen Test ein angenehmeres Erlebnis, da die Testteilnehmer nicht auf eine große Anzahl von Elementen stoßen, die deutlich unter oder über ihrem tatsächlichen Kompetenzniveau liegen. Dieser leistungsstarke Testaufbau- und Bereitstellungsansatz ist nur durch eine psychometrische Technik namens Item-Response-Theorie (IRT) möglich. Bei der IRT ist jedes einzelne Testelement (auch bekannt als Testfrage) mit seinem eigenen wissenschaftlich gemessenen Schwierigkeitsgrad verbunden. Im Falle von STAMP wird der Schwierigkeitsgrad jedes Elements im Test durch eine IRT-Analyse der Antworten von Hunderten (und in vielen Fällen Tausenden) repräsentativer Testteilnehmer berechnet. Dies ermöglicht es uns, die Elemente hinsichtlich ihrer Schwierigkeit zu kalibrieren und sicherzustellen, dass nur die allerbesten Elemente in jedem STAMP Test verwendet werden.

Der STAMP Bewertungsalgorithmus nutzt ebenfalls diese Informationen zur Schwierigkeit der Aufgaben, um das endgültige STAMP Niveau jedes Prüflings zu berechnen, basierend auf den Aufgaben, die sie während des Tests versucht haben, ihrer Antwort auf jede Aufgabe und der Fähigkeit, die Prüflinge zeigen müssen, um auf jedem der STAMP Niveaus zu punkten (letzteres wird durch einen Prozess namens Standard Setting bestimmt). Daher ist es aufgrund der adaptiven Natur der STAMP Bewertungen und der Tatsache, dass jede Aufgabe mit einem bestimmten statistischen Schwierigkeitsgrad verbunden ist, weder sinnvoll noch angemessen, die STAMP Ergebnisse in Bezug auf die Anzahl der richtigen Antworten (z.B. 23 von 30) oder den Prozentsatz der richtigen Antworten (76,6%) zu berichten.

Wie wir bald diskutieren werden, verwendet die Item-Response-Theorie (IRT), die die statistische Grundlage für die Entwicklung und Bewertung der Avant STAMP Tests bildet, eine Bewertungsskala, die für Endbenutzer der STAMP Tests nicht sehr intuitiv ist. Zum Beispiel hat die IRT-Skala sowohl negative als auch positive Werte. Einem Testteilnehmer in ihrem Ergebnisbericht zu sagen, dass ihre Lesekompetenz im deutschen STAMP 4S Test -1,4 ist, wäre nicht hilfreich und würde gegen die Anforderung an klare und leicht zu verwendende Ergebnisse verstoßen, die oben besprochen wurde. Aus diesem Grund ist es notwendig, dass die STAMP Ergebniswerte, die auf der IRT basieren, in eine aussagekräftigere und leichter interpretierbare Ergebnisskala umgewandelt werden. Eine Skala ist im Grunde ein Spektrum potenzieller Messwerte und Testentwickler müssen die Referenzpunkte der Ergebnisskala festlegen, bevor die Ergebnisse gemeldet werden können.

Verständnis der Referenzpunkte einer Skala

Drei Skalen, mit denen die Leser wahrscheinlich vertraut sind, sind die Celsius-, Fahrenheit- und Kelvin-Temperaturskalen. Obwohl alle drei Temperaturskalen sind, unterscheiden sich ihre Referenzpunkte und Interpretationen erheblich. Das Gleiche kann für verschiedene Skalen gelten, die zur Berichterstattung von Sprachkenntnispunkten verwendet werden.

In der Celsius-Skala zeigt ein Grad von 0 ℃ den Messpunkt an, an dem Wasser auf Meereshöhe gefriert, während der niedrigstmögliche Messwert auf der Celsius-Skala -273,15 ℃ ist, was dem Punkt entspricht, an dem in einer Substanz überhaupt keine molekulare Aktivität vorhanden ist. Auf der Fahrenheit-Skala hingegen ist der Messpunkt, an dem Wasser auf Meereshöhe gefriert, 32 Grad F, nicht 0 Grad F. Auf der Fahrenheit-Skala zeigt - 459,67 F den niedrigstmöglichen Messwert an, wenn in einer Substanz keine molekulare Aktivität vorhanden ist. Wie wir sehen können, bedeutet eine Null in weder der Celsius- noch der Fahrenheit-Skala tatsächlich das vollständige Fehlen von etwas. Es handelt sich einfach um einen Referenzpunkt, der nur im Hinblick auf die vollständige Skala und ihre möglichen, erreichbaren Werte Sinn macht.

Für die Temperaturskalen ist die einzige Skala, die einen echten Nullpunkt hat, die Kelvin-Skala. In der Kelvin-Skala bedeutet der Messpunkt 0 K tatsächlich keine molekulare Aktivität überhaupt, wobei Null den minimal möglichen Wert in der Kelvin-Skala markiert. In der Kelvin-Skala sind daher negative Werte nicht möglich, anders als bei den Celsius- und Fahrenheit-Skalen (und wie wir gleich sehen werden, der IRT-Skala). Alle drei Temperaturskalen haben keine wirkliche Grenze für ihre maximalen Werte, da es keine bekannte Grenze dafür gibt, wie heiß etwas sein kann.

Können wir nun wirklich sagen, dass eine Skala besser ist als die andere? Nicht wirklich. Alle drei Skalen sind für sich genommen völlig gültig und werden in verschiedenen Kontexten weit verbreitet eingesetzt, wobei bestimmte Skalen je nach spezifischem Kontext von den Benutzern als angemessener erachtet werden. Eine Sache, die diese drei Skalen jedoch vereint und sie perfekt geeignet für präzise Messungen macht, ist die Tatsache, dass der Abstand zwischen zwei beliebigen Messpunkten auf der Skala den gleichen Temperaturunterschied anzeigt. Mit anderen Worten, der Unterschied in der molekularen Aktivität zwischen 35 ℃ und 37 ℃ ist genau der gleiche wie der zwischen 89 ℃ und 91 ℃. Dies ist eine Eigenschaft, die wir bei Avant für das Herzstück guter Messung halten und sicherlich eine, die wir für unsere STAMP-Bewertungen verwenden.

Trotz der Nützlichkeit, die drei bekannten Temperaturskalen oben zu betrachten und zu sehen, wie passend sie in ihren gegebenen Kontexten für die Messung eines Konstrukts wie der Temperatur sind, ist es wichtig zu verstehen, dass einige der Eigenschaften, die sie besitzen, sie ungeeignet für die Messung eines Konstrukts wie der Sprachkompetenz machen. Zum Beispiel wäre es nahezu unmöglich zu erklären, was negative Sprachkompetenz bedeutet oder wie jemand null Fähigkeiten in einer Sprache haben kann; selbst eine Person, die noch nie eine bestimmte Sprache gelernt oder Kontakt mit ihr gehabt hat, wird zumindest einige (wenn auch minimale) Kenntnisse von zumindest entlehnten Wörtern in dieser Sprache haben. Kein Sprachkompetenztest kann behaupten, dass jemand null Sprachkompetenz hat, da es für einen gegebenen Test unmöglich wäre, alle möglichen Szenarien zu bewerten, in denen eine Person zumindest ein sehr grundlegendes Verständnis eines Wortes oder einer Phrase in der Sprache zeigen könnte. Alle Sprachtests sind durch die in dem Test vorhandenen Elemente und das, was sie messen können, begrenzt, was bedeutet, dass Sprachtests möglicherweise keinen Nullpunkt der Messung haben, aber einen Mindestmesspunkt haben könnten, der den Punkt darstellt, unter dem der Test keine Aussagen treffen kann. Das Gleiche gilt für den maximalen Referenzpunkt in einem Test; egal wie viele Elemente ein Test enthält, er wird niemals in der Lage sein, alle Sprachkompetenzen einer Person zu messen. Daher wird eine gültige Skala für einen Sprachkompetenztest wie den STAMP-Tests einen Mindestreferenzpunkt haben (der für Testteilnehmers verwendet wird, die alle Testelemente, die sie gesehen haben, falsch beantworten), keinen Nullreferenzpunkt und einen maximalen Referenzpunkt haben (der für Testteilnehmers verwendet wird, die alle Testelemente, die sie gesehen haben, richtig beantworten).

IRT-Messung und die STAMP-Punktzahlen

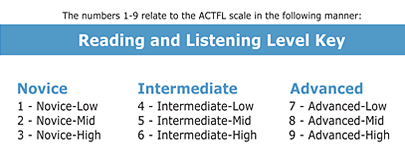

Wie oben erwähnt, ist es wichtig, dass gleiche Intervalle in einer Skala, die zur Berichterstattung von Ergebnissen eines Sprachkompetenztests verwendet wird, den gleichen Unterschied in der Sprachkompetenz anzeigen. Alle Stufen des STAMP-Tests (Stufen 1 - 9) sind an die US-Sprachkompetenzstandardstufen (Novice Low bis Advanced High) angepasst, wie unten zu sehen ist:

Trotz der Ausrichtung der STAMP-Stufen auf diese Kompetenzstufen und trotz der Nützlichkeit der Kompetenzstufen zur Angabe des allgemeinen Sprachfähigkeitsniveaus eines Testteilnehmers, entsprechen die Standardstufen selbst nicht der Art von numerischen skalierten Werten, die wir suchen. Erstens ist die Bedeutung des Intervallunterschieds in den nationalen Sprachkompetenzstandards (und daher STAMP)-Stufen nicht gleich, unabhängig von dem Punkt auf der Skala. Zum Beispiel erfordert es eine höhere Sprachfähigkeit, von Intermediate High (STAMP Stufe 6) zu Advanced Low (STAMP Stufe 7) zu wechseln, als von Novice High (STAMP Stufe 3) zu Intermediate Low (STAMP Stufe 4) zu wechseln. Aus genau diesem Grund werden die Kompetenzstufen als umgekehrte Pyramide und nicht als Quadrat oder Rechteck dargestellt. Zweitens, trotz der Nützlichkeit der Kompetenzstufen zur Angabe, wo ein bestimmter Sprachlerner in Bezug auf seine Sprachkompetenz steht, können Studenten, die auf der gleichen STAMP-Stufe abschneiden, tatsächlich leicht unterschiedliche Fähigkeiten in der Sprache haben und möglicherweise unterschiedliche Anzahlen von Aufgaben korrekt im STAMP-Test beantwortet haben, selbst wenn sie genau die gleichen Aufgaben durch den STAMP adaptiven Algorithmus gesehen haben. Daher sind diese Stufen, trotz der wichtigen Nützlichkeit der STAMP- und nationalen Sprachkompetenzstandardstufen zum Verständnis der Sprachkompetenz der Testteilnehmer, nicht so feinkörnig, wie es einige Endnutzer unserer Testergebnisse gerne hätten.

Zum Beispiel könnte eine Schule nur zehn Plätze in einem besonderen Ehrenabschnitt des Französischen Lesens haben. Was ist, wenn vierzehn der Schüler ein STAMP Level 9 im Lesen erreicht haben? Wie kann die Schule 10 von den 14 Schülern für den Ehrenkurs auswählen? Zehn zufällig auszuwählen, könnte als akzeptable Lösung angesehen werden, aber wir bei Avant Assessment können eine bessere und genauere Art der Hilfe in diesem Fall bieten. Wie oben erwähnt, nutzt Avant Assessment eine statistische Messmethode namens Item Response Theory , um alle Elemente in den Lesen- und Hören-Abschnitten der (adaptiven) STAMP Tests zu kalibrieren, um die Anzahl der Fragen, die ein Testnehmer in seinem spezifischen Testpfad richtig beantwortet, mit den STAMP-Levels und daher den nationalen Kompetenzstandards, auf die sie ausgerichtet sind, in Einklang zu bringen und schließlich skalierte Punktzahlen zu erzeugen, die den Punktenutzern ein feiner abgestimmtes Maß für die Sprachfähigkeit jedes Testnehmers bieten, als dies möglich wäre, wenn nur die STAMP-Levels gemeldet würden.

Skalierung der STAMP Punktzahlen

Sobald alle Elemente in einem spezifischen Abschnitt eines STAMP Tests durch IRT kalibriert wurden, sind wir in der Lage, jedem Schüler eine IRT-Fähigkeitsschätzung (auch als Theta in der IRT-Terminologie bezeichnet) zuzuweisen, basierend auf den Elementen, die sie in dem spezifischen Pfad, den sie in jedem der Lese- und Hörabschnitte ihres STAMP Tests verfolgt haben, richtig oder falsch gemacht haben. Sobald wir diesen Wert haben, sind wir dann in der Lage, diesen Wert zu skalieren (daher der Begriff, Score-Skalierung), damit wir genauere Scores melden können, um die Berichterstattung über das erreichte STAMP Level zu ergänzen. Durch die Skalierung der IRT-Scores sind wir dann in der Lage, sicherzustellen, dass alle skalierten Scores positiv sind (keine negativen Werte) und dass Score-Nutzer, wie die hypothetische französische Schule oben, mehr auf die Kompetenz der Schüler eingehen können, selbst wenn die Schüler zufällig auf dem gleichen STAMP Level abgeschnitten haben.

Jeder der Lese- und Hörabschnitte jedes STAMP Tests muss separat skaliert werden. Daher können skalierte Punktzahlen für Spanisches Lesen nicht direkt mit skalierten Punktzahlen für Spanisches Hören oder mit skalierten Punktzahlen für Chinesisches Lesen verglichen werden. Mit anderen Worten, die STAMP skalierten Punktzahlen sind sprach- und abschnittsspezifisch.

Wir skalieren die IRT-Punkte in den Lese- oder Hörabschnitten jedes unserer Tests durch eine einfache lineare Transformation, die in der untenstehenden Formel zu sehen ist:

Die oben genannte Skalierung stellt sicher, dass alle möglichen skalierten Punktzahlen für einen gegebenen Abschnitt eines STAMP Tests positive Zahlen ohne Dezimalstellen sind, was viel intuitiver ist als Punktzahlen, die von -4 bis +4 reichen, was für IRT typischer ist. Die lineare Skalierung, die in der obigen Formel zu sehen ist, stellt auch sicher, dass der Abstand zwischen zwei skalierten Punktzahlen an jedem Punkt der Skala den gleichen Unterschied in der Fähigkeit anzeigt.

Interpretation der skalierten Punktzahlen

Stellen Sie sich vor, wir haben die folgenden Schüler, die den Hörverstehensabschnitt des japanischen STAMP 4S-Tests absolviert haben:

- Student A skalierte Punktzahl: 589

- Student B skalierte Punktzahl: 612

- Student C skalierte Punktzahl: 677

- Student D skalierte Punktzahl: 700

Der Unterschied in der japanischen Hörverständnisfähigkeit zwischen Student A und Student B in Japanisch (23 skalierte Punkte) ist derselbe wie der Unterschied in der japanischen Hörverständnisfähigkeit zwischen Student C und Student D (23 Punkte). Wenn zwei Schüler das gleiche STAMP Niveau im Japanischen Hörverständnis erreicht haben (z.B., STAMP Level 4 - Intermediate Low), aber einer von ihnen einen skalierten Score hat, der 20 Punkte über dem anderen liegt, haben wir starke Unterstützung zu glauben, dass der Schüler mit dem höheren skalierten Score kompetenter ist als der Schüler mit dem niedrigeren skalierten Score. Je größer der Unterschied zwischen ihren skalierten Scores, desto sicherer können wir sein, dass der Unterschied bedeutungsvoll ist und dass die beiden Schüler tatsächlich nicht gleich kompetent sind. Die skalierten Scores können auch nützlich sein in Fällen, in denen ein Schüler nach einem Jahr des Studiums scheinbar keine Fortschritte macht und auf dem gleichen Kompetenzniveau "stecken" bleibt. Ein Vergleich zwischen ihrem skalierten Score vor einem Jahr und ihrem skalierten Score aus der aktuellen Verwaltung könnte kleine inkrementelle Gewinne in ihrer Kompetenz zeigen, auch wenn solche Zuwächse nicht ausreichend waren, um sie in das nächste STAMP Level zu versetzen.

Eine Sache sollte jedoch im Hinterkopf behalten werden: alle Bewertungen haben einen bestimmten Messfehler, der mit ihren Ergebnissen verbunden ist. Zum Beispiel beträgt der standardmäßige Messfehler (SEM), den ETS für den Hörabschnitt des TOEFL iBT meldet, der eine Punkteskala von 0 - 30 verwendet, 2,38 skalierte Punkte (Educational Testing Services, 2018). Im Gegenzug beträgt der standardmäßige Messfehler für die SAT-Abschnittsergebnisse, mit einer Punkteskala von 200 - 800, 30 Punkte (College Board, 2018). Da es nicht machbar ist, jeden Schüler an vielen verschiedenen Tagen und über Hunderte von Testelementen zu bewerten, ist jedes Testergebnis ein Schnappschuss des Niveaus, das ein gegebener Testteilnehmer an diesem spezifischen Tag, an dem sie den Test gemacht haben, und über die spezifischen Elemente, die sie während ihrer Testverwaltung beantwortet haben, aufrechterhalten konnte. Natürlich wird ein Test wie der STAMP 4S, dessen Lesen- und Hören-Abschnitte computeradaptiv sind, der eine große Anzahl von Elementen beinhaltet, die das geschätzte Niveau jedes Testnehmers in Echtzeit abzielen, und der nach strengen qualitativen und quantitativen Standards entwickelt wird, tendenziell einen kleineren Messfehler haben und effektiver und effizienter sein als kürzere, nicht adaptive, lineare Tests, die nicht die gleiche Strenge befolgen (Schultz, Whitney, & Zickar, 2014). Der durchschnittliche standardmäßige Messfehler für die skalierten Ergebnisse in den Lesen- und Hören-Abschnitten der STAMP-Tests beträgt 10 skalierte Punkte. Diese Statistik lässt sich leicht aus der Art der IRT-Software ableiten, die wir bei Avant verwenden.

Der Messfehler, der mit den skalierten STAMP-Ergebnissen verbunden ist, ist angesichts der psychometrischen Strenge und der adaptiven Natur unserer Tests recht gering. Obwohl wir empfehlen, dass die Analysen der Testergebnisse hauptsächlich auf der erreichten STAMP-Stufe basieren sollten, schlagen wir bei Avant vor, dass skalierte Ergebnisse in sehr spezifischen Fällen berücksichtigt werden können, wenn Entscheidungen mit höheren Einsätzen auf der Grundlage der STAMP-Testergebnisse getroffen werden sollen, wie zum Beispiel wenn die STAMP-Ergebnisse zur Vergabe von State Seals of Biliteracy (SSB) oder zur Vergabe von Krediten durch Prüfungen (CBE) verwendet werden. In solchen Fällen mit höheren Einsätzen, wenn die skalierte Punktzahl eines Prüflings im Lesen oder Hören zufällig 10 Punkte oder weniger unter der minimalen skalierten Punktzahl liegt, die sie für das SSB oder CBE qualifizieren könnte, ist Avants Position, dass eine Schule oder ein Bezirk nach eigenem Ermessen solche Prüflinge den STAMP-Test erneut ablegen lassen kann (aufgrund seiner adaptiven Natur besteht eine gute Chance, dass die Testteilnehmer nicht genau die gleichen Elemente wie in der vorherigen Verwaltung sehen werden). Wenn bei dieser zweiten Verwaltung die skalierte Punktzahl des Testteilnehmers zu einer STAMP-Stufe führt, die die Anforderungen für das SSB oder CBE erfüllt, ist Avants Position, dass die Ergebnisse dieser zweiten Verwaltung anstelle der Ergebnisse der ersten Verwaltung verwendet werden können.

Die beiden oben diskutierten Szenarien sind Szenarien mit höheren Einsätzen, bei denen die Berücksichtigung der geringen Fehlerquote des Tests gerechtfertigt sein könnte (denken Sie daran, dass alle Tests eine Fehlerquote haben).

Wir empfehlen generell, die skalierten STAMP-Punkte für traditionelle Anwendungen wie die fortlaufende jährliche Analyse oder das Wachstum der Schüler und für die Programmbewertung zu verwenden.

Um die Tabellen der derzeit verfügbaren skalierten Punktzahlen für die STAMP-Bewertungen zu sehen, klicken Sie hier.

Referenzen:

College Board (2018). SAT: Verstehen von Punktzahlen. Abgerufen von https://collegereadiness.collegeboard.org/pdf/understanding-sat-scores.pdf

Educational Testing Services (2018). Zuverlässigkeit und Vergleichbarkeit von TOEFL iBT-Ergebnissen. TOEFL Research Insight Series (Band 3). Abgerufen von www.ets.org/s/toefl/pdf/toefl_ibt_research_s1v3.pdf

Schultz, K. S., Whitney, D. J., & Zickar, M. J. (2014). Messungstheorie in Aktion. Fallstudien und Übungen (2. Aufl.). London/New York: Routledge. College Board (2018). SAT: Verständnis der Ergebnisse. Abgerufen von https://collegereadiness.collegeboard.org/pdf/understanding-sat-scores.pdf

Educational Testing Services (2018). Zuverlässigkeit und Vergleichbarkeit von TOEFL iBT Scores. TOEFL Research Insight Series (vol. 3). Abgerufen von www.ets.org/s/toefl/pdf/toefl_ibt_research_s1v3.pdf

Schultz, K. S., Whitney, D. J., & Zickar, M. J. (2014). Messungstheorie in Aktion. Fallstudien und Übungen (2. Aufl.). London/New York: Routledge.